Hoe voorkomen organisaties discriminatie bij het ontwerp van AI?

Te rechtvaardigen

Directe en indirecte discriminatie zijn verboden, maar onderscheid maken tussen groepen kan voor organisaties legitiem en te rechtvaardigen zijn. ‘Dat is zo als er sprake is van een legitieme reden om het onderscheid te maken, als het maken van onderscheid proportioneel is en als er geen minder ingrijpende middelen ter beschikking staan om hetzelfde doel te bereiken’, schrijven de onderzoekers.

De juiste vragen

Systeembouwers moeten zich bewust zijn van de basis waarop het AI-systeem onderscheid maakt en of dat te rechtvaardigen is: ‘Is het onderscheid bedoeld of onbedoeld; is het relevant of niet?’ Dat is afhankelijk van de context – iets waar een rechter altijd rekening mee zal houden. Om de juiste vragen te stellen over de technische, juridische en organisatorische voorwaarden, ontwikkelde het onderzoeksteam de handleiding.

Verdacht onderscheid

Een vraag over bewustwording is bijvoorbeeld: ‘Is er bij mijn doel, design of uitkomst sprake van mogelijk ‘verdacht’ onderscheid?’ Als er onderscheid wordt gemaakt, is de vraag of die leidt tot benadeling: ‘Ik wil een AI systeem bouwen dat die personen met een dubbele nationaliteit in mijn data er uit filtert en aanmerkt voor extra controle’ verwijst naar ‘De groep wordt extra gecontroleerd en ondervindt daarvan negatieve consequenties.’

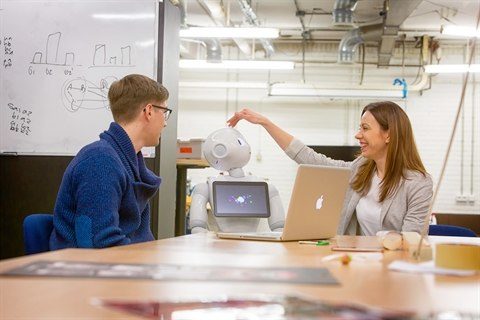

Betrek belanghebbenden

Er zijn zes stappen voor het ontwikkelen en toepassen van algoritmen, van het vaststellen van de probleemdefinitie tot het toetsen van beleid, en per stap worden de juridische regels en best practices gegeven. Belanghebbenden en relevante groepen in de samenleving moeten vanaf het begin worden betrokken, onafhankelijke experts moeten kritisch blijven meekijken en personen over wie automatische besluiten worden gemaakt, moeten daarvan op de hoogte zijn en bezwaar kunnen aantekenen. Bij fouten moet het proces worden gestopt.

Lokaal algoritmegebruik

In april wees de Rotterdamse rekenkamer op de risico’s in het lokale algoritmegebruik en begin 2020 was de geruchtmakende uitspraak van de rechtbank in Den Haag dat de inzet van SyRI ‘onrechtmatig’ was want het vormde een te grote inbreuk op de privacy van burgers.